华为“凶猛”,黄仁勋没有退路|深度

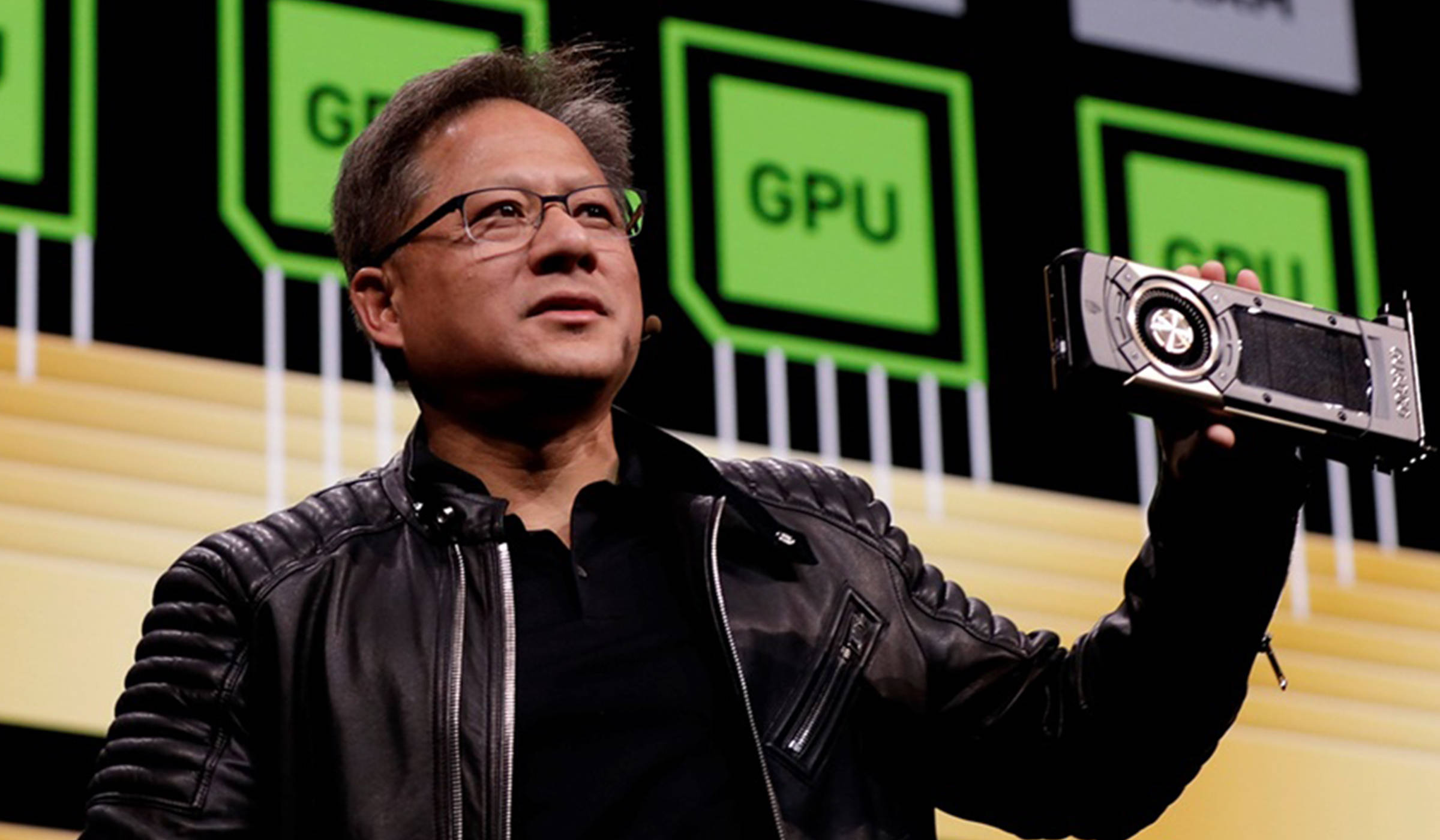

(图片来源:NVIDIA官网)

就在全球AI龙头英伟达(NVIDIA)财报发布数小时前,华为再度隔空“硬碰硬”。

5月29日凌晨,华为技术团队在Gitcode平台上发布Pangu Ultra MoE万亿规模大模型技术报告,其拥有约7180亿参数规模的结构,首次全流程在昇腾Ascend 910上进行训练,显著提升推理吞吐并降低延迟,并且融合大算子和通信优化有效提升了NPU利用率,从而有效提高训练过程的稳健性。

而昨天,华为盘古还发布基于分组混合专家模型(MoGE)架构构建的盘古Pro MoE大模型,参数规模720亿,基于昇腾300I Duo和800I A2实现了更优专家负载分布与计算效率(321 tokens/s 和 1528 tokens/s)。

更早之前,华为技术团队称昇腾在MoE模型的推理部署性能已全面超越了基于英伟达Hopper架构的推理部署性能,而DeepSeek基于国产芯片的部署方案,性能也已超越英伟达H100系列芯片。另外,华为“CloudMatrix 384超节点”技术在算力规模和推理性能上也全面超越英伟达NVL72。