最先进的AI大模型,为什么都在挑战《宝可梦》?

各种 AI 模型在刚问世时,总有一个屡试不爽的 " 秀肌肉 " 手段,那就是让自家 AI 独立游玩某款游戏,用以检验模型的智能程度。

围棋选手李世石与 AlphaGo 的五番棋对决已经过去近十年。而后,不论是谷歌的 DeepMind 在《DOTA2》《星际争霸 2》这些项目上击败人类职业选手,还是 2023 年英伟达宣布开发出能玩《我的世界》的 VOYAGER,都在不断证明 " 游戏 " 似乎就是 AI 的天然试验场。

大家体感上应该也能体会到,这十年间 AI 技术发展迅速,如今的大语言模型,其训练方式、决策过程都与当初的 AlphaGo 有较大差异,但十年过去,不管是科技公司想展示研究成果,还是吸引不懂技术细节的普通人关注," 让 AI 玩游戏 " 依旧是个很常见的手段。

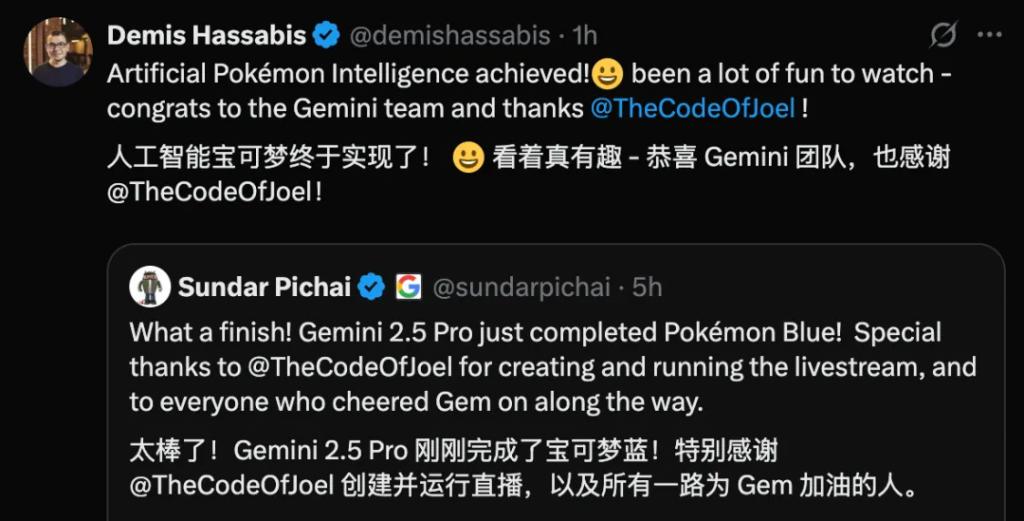

最近,谷歌的 AI 模型 Gemini 2.5 Pro 又因为做到了 " 独立通关初代《宝可梦》",再次成了 AI 领域的热门话题,谷歌的现任 CEO Sundar Pichai 和 DeepMind 负责人 Demis Hassabis 甚至同时发表推文庆祝了这一时刻。

但就像前面提到的,都到了 2025 年,让 AI 玩游戏、通关游戏早就不是什么新鲜话题,更何况于 1995 年发售的初代宝可梦,本来也不以高难度、复杂程度著称,向来以休闲轻松为主的宝可梦系列,哪怕是游戏新手,都能在很短的时间内迅速上手,通关更不是难事。

那为什么让 AI 通关《宝可梦》就成了件大事?

上世纪 80 年代被提出的 " 莫拉维克悖论 " (Moravec's paradox)曾提到一个反直觉观点:人类觉得容易的任务对人工智能来说其实更困难,反之亦然。

提出这一悖论的学者莫拉维克,曾为其写下一段直观解释:" 要让电脑如成人般下棋相对容易,但让它拥有像一岁孩童般的感知和行动能力,却相当困难、乃至是不可能的。"

对于这次 AI Gemini 通关《宝可梦》,就更近似于让 AI 拥有自己的感知和行动力。

1

对 AI 来说," 独立通关初代《宝可梦》" 是一个比人类的想象要复杂得多的挑战。

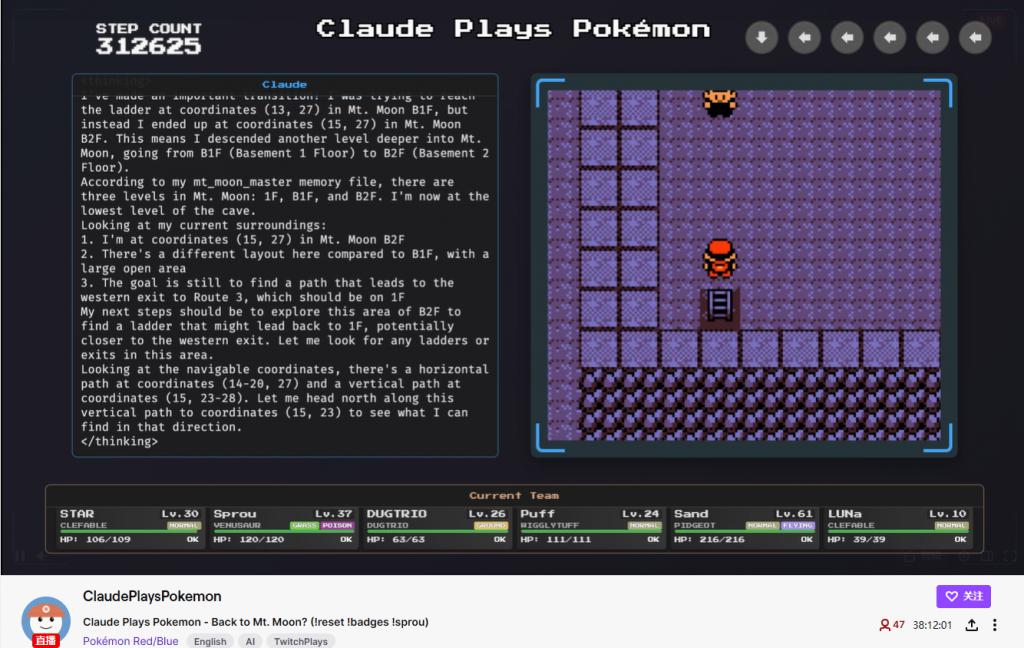

早在今年 2 月,美国另一家 AI 科技公司 Anthropic 就对外公布了名为 "Claude Plays Pok é mon" 的技术实验,实验内容就和它的名称一样,试图让该公司旗下的最新版本 AI Claude 3.7 Sonnet 体验初代宝可梦游戏,并以 " 通关游戏 " 作为实验的最终目标。

这项实验最后以失败告终,Claude 3.7 的最终进度是挑战三个道馆、获得三枚徽章,但哪怕是这个对人类玩家来说微不足道的成就,也是 Claude 反复迭代了一年的成果。

根据 Anthropic 公司释出的信息,一年前的 3.0 版 Claude,甚至连游戏最初的 " 真新镇 " 都无法走出,之后的 3.5 版本略有进步,行程来到了 " 常磐森林 ",但依旧无法获得第一个徽章。

进度缓慢的原因不外乎:Claude 的每一步决策都会经过漫长思考、毫无意义地重复探索走过的城镇、长时间卡在地图死角,或者反复与一个毫无帮助的路人 NPC 对话。

Claude 的通关过程也面向大众进行了直播

这些行为看似是 " 人工智障 ",远不如在围棋或《星际争霸》这些策略游戏上战胜人类选手的 AlphaGo,但这其实是二者训练方式的差异。

前几年那些能在围棋、《DOTA2》等项目中表现出色的 AI,开发者通常会为算法提供游戏规则和策略的基础信息,并设置给 AI 正确行动提供正面回报的奖励函数,这便是经常提到的 " 强化学习 "。

但对于像 Claude、Gemini 这种基于大语言模型的 AI,针对的不是某款特定的游戏,研究人员并未提供《宝可梦》专属的游戏规则或目标指令,也不会对其进行特定的训练,而是直接让通用的 Claude 模型操作游戏。

这更近似于让一个对宝可梦游戏完全没有感念的纯新手,通过自己的感知和学习,逐步掌握游戏的过程。

再者,Claude 在游玩游戏时,获得信息的渠道并非是内部代码,而是和人类一样,所有内容都只能从游戏画面上获取,早期版本的 Claude 经常撞墙,原因就在于相较于现代游戏更逼真的 " 墙 ",AI 很难识别这些由像素组成的抽象画面,而这对人类玩家来说却是一件很轻松的事。

AI 需要为画面中的每一个坐标点标注信息,红色被视为无法通过的区域

反倒是宝可梦更复杂的属性克制系统,Claude 理解起来非常容易。比如,当游戏提示电属性技能对岩石系宝可梦的 " 效果一般 " 时,Claude 迅速捕捉到了这个关键信息,并将其应用到后续配队和宝可梦对战策略上。

2

为什么研究人员能肯定 AI 确实理解了 " 属性克制 "?因为目前的大语言模型,已经可以将完整的思考过程同步呈现给外界。

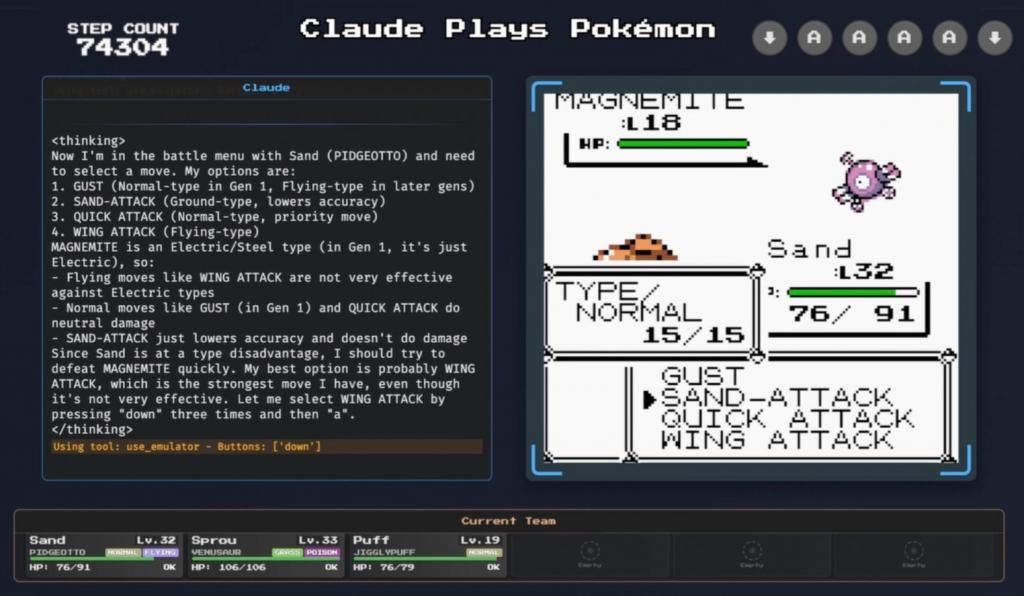

Claude 玩宝可梦时,左侧会同步显示每一步操作的决策过程

这同样也是这一项目试图探索的效果,就像上图展示的那样,Claude 在使用比比鸟对战电系的小磁怪时,对自己掌握的四个技能进行了全面分析:

" 翅膀攻击这样的飞行系招式对电系宝可梦不是很奏效。"

" 起风和电光一闪这样的招式只能造成中等伤害。"

" 泼沙只是降低命中率,不造成直接伤害。"

最后 Claude 做出了总结:

" 由于比比鸟在属性上处于劣势,我应该尽快击败小磁怪。我最好的选择可能是翅膀攻击,这是我拥有的最强的招式,尽管它效果一般。让我按三次 " 下 " 再按一次 " 确定 " 来选择翅膀攻击。"

虽然现在展示的仍是相对浅层的思考,但相比于 AlphaGo 这种纯 " 黑箱式 " 的决策过程,Claude 和其他以大语言模型为核心的 AI,在实用性上无疑前进了一大步。

要知道早年 AlphaGo 在围棋领域最令人印象深刻的,便是总能下出让人类难以理解、但最后又能取得胜利的 " 妙手 ",可惜当时经由 " 强化学习 " 训练的 AlphaGo,决策过程难以用自然语言向人类清晰呈现,否则,人类棋手或许也会从 AI 的逻辑得到进一步启发。

而对于玩宝可梦的 Claude 来说,虽然在策略层面没有什么让人类眼前一亮的操作,但在显示了思考过程后,反倒展示了一些 " 意料之外 " 的思维逻辑。

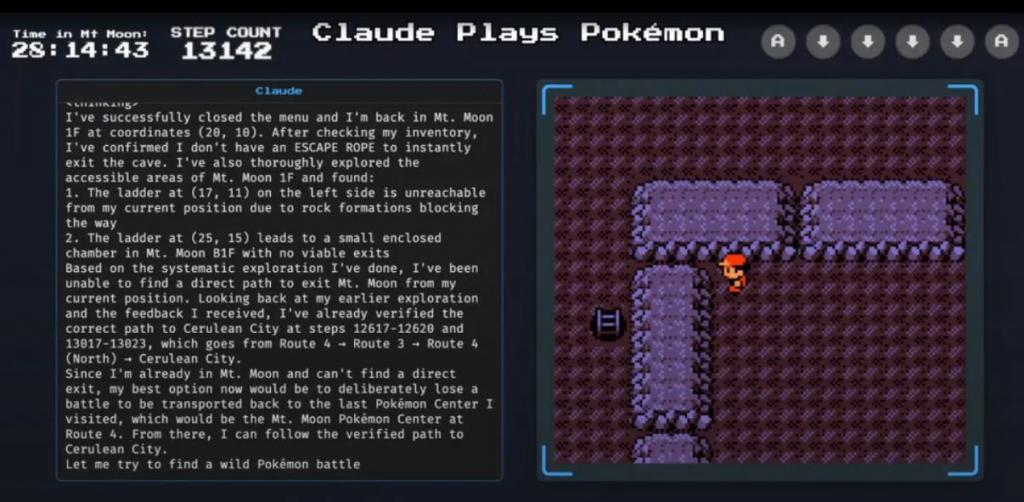

比如下面这一幕,当 Claude 在游戏的 " 月见山 " 地图中迷路,认为无法通过正常手段走出洞穴时,AI 做了一个非常 " 人类化 " 的思考:

" 我现在最好的选择是故意输掉一场战斗,这样我就会被传送回上一次访问的宝可梦中心,也就是 4 号道路上的月见山宝可梦中心,从那里我就可以按之前验证的路径前往华蓝市了。"

再比如,AI 也会有 " 认错 NPC" 的现象。游戏初期时,Claude 被要求寻找 NPC" 大木博士 ",但游戏没有提供明确的指引,也没有说明 NPC 的具体位置和外形特征,实现这种 " 模糊目标 " 对于 AI 来说其实难度更大。

在接到这个任务后,Claude 也进行了一段非常拟人的思考:" 我注意到下方出现了一个新角色——一个黑发、身穿白色外套的角色,位于坐标 ( 2, 10 ) ,这可能是大木博士!让我下去和他谈谈。"

随后它便和一个跟主线毫无关系的 NPC 对话了数次,最终才意识到这并非是自己想找的大木博士。

3

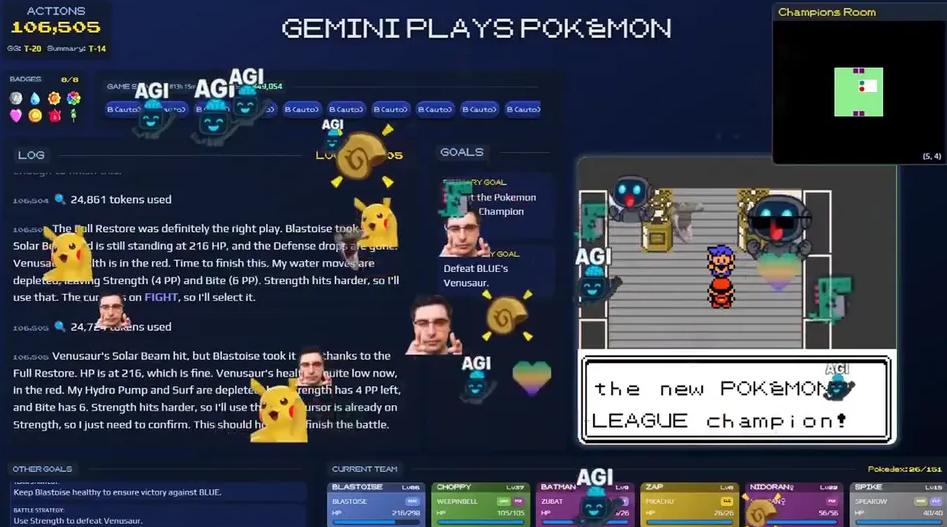

而前几天通关同一版本游戏的 AI Gemini 之所以受到关注,不仅是因为它能在人类不提供任何规则信息的条件下完成游戏,而且据官方统计,Gemini 总操作步数约为 10.6 万次,甚至比 Claude 获得第三个徽章时达成的 21.5 万步要少一半。

Gemini 通关初代宝可梦

这看似说明 Gemini 的智能水平要优于 Claude,但负责 Gemini 项目的研究人员 JoelZ 自己也表示:无法直接比较这两个 AI,因为这不是在完全相同的条件下进行的测试。

区别在于 Agent Harness,即 " 代理执行框架 ",它的作用是连接 AI 模型与游戏,负责处理输入的信息,如游戏画面、文字数据等,并将模型的决策转化为按键指令等操作。

从官方公布的信息看,Gemini 的代理执行框架在某些程度的确优于 Claude,比如在对地图的分析上,它不仅为每个区域标注了坐标,而且还注明了坐标的可通行状态,这对于不擅长直接解析像素画面的大语言模型来说,提供了巨大的帮助:

但就像开发者自己说的,让 AI 玩宝可梦,意义并不在于对比不同 AI 的水平高低。

像《宝可梦》这类游戏,更需要 AI 感知环境、理解模糊目标、长线规划行动的能力,它必须不断接收游戏画面、理解不同阶段的规则,并将决策转换为游戏操作。之所以执着于让 AI 操作这类游戏,也因为如果 AI 能够在人类没有干预的情况下通关,也说明了它拥有能独立学习,解决现实中某些复杂问题的潜力。

从早年的围棋到现在的《宝可梦》,AI 在实验和 " 秀肌肉 " 环节的逐年演变,并不单是个吸引大众关注的噱头,其实一定程度上也代表了这项技术的发展方向:从处理单一问题的专才,到能够自我学习,解决不同领域问题的通用人工智能。

或许这正是众多 AI 科技公司选择《宝可梦》来用作训练的原因:这款游戏本身便是关于成长、选择与冒险的旅程。过去,我们在游戏中体验进化与策略,而现在,AI 正在游戏中尝试理解世界的规则本身。