英特尔存储业务回归,将联手软银合作开发功耗减半的AI存储芯片

近日,日本软银集团(SoftBank)与美国英特尔公司(Intel)已达成合作,共同开发一种新型的低功耗人工智能存储芯片。这个名为“Saimemory”的合作项目,旨在研发出性能媲美当前主流高带宽存储器(HBM,High Bandwidth Memory),但功耗降低一半以上的创新产品,预示着 AI 硬件领域可能迎来一次重要的能效革命。

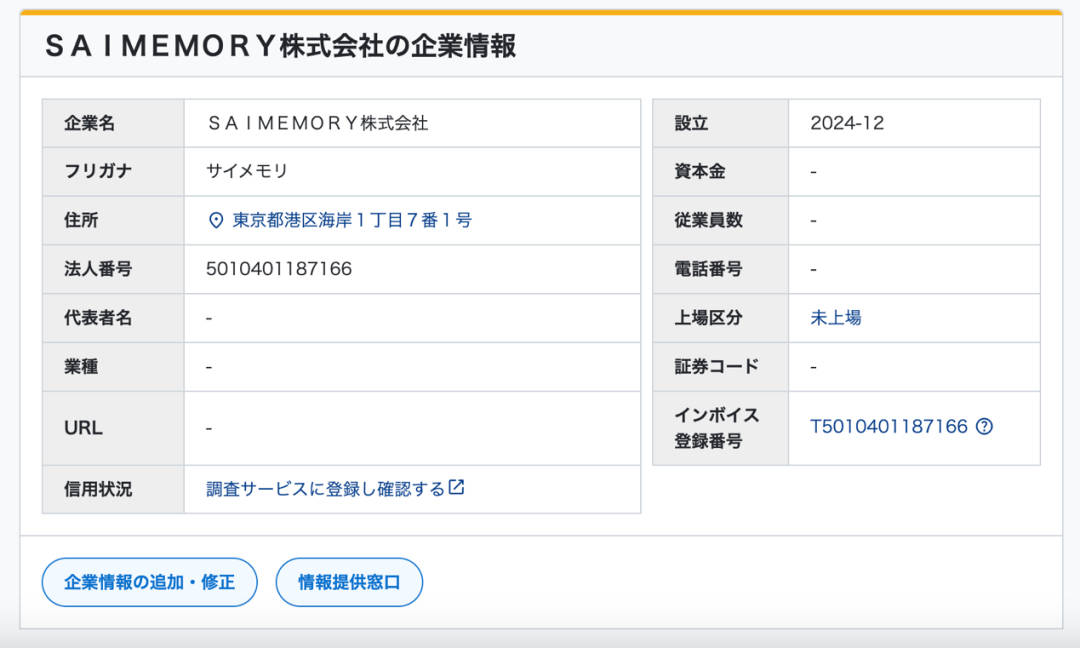

据报道,两家公司为此合作已成立一个名为“Saimemory”的实体公司。The Register 通过公司注册记录发现,确有一家公司在 2024 年末更名为 Saimemory。Saimemory 的核心使命是研发一种创新的堆叠式动态随机存取存储器(DRAM,Dynamic Random Access Memory)技术,它被定位为当前 AI 服务器中广泛采用的 HBM 的有力替代品。尽管 HBM 在 AI 领域展现出卓越的性能,但其高昂的成本、巨大的功耗以及复杂的制造工艺一直是行业面临的挑战。Saimemory 的目标则是在提供与 HBM 相媲美的高带宽性能的同时,显著降低能源消耗,力求达到现有产品能耗的一半甚至更低。

图丨该公司注册记录(来源:Alarmbox)

图丨该公司注册记录(来源:Alarmbox)

项目的初步目标是在未来两年内完成原型芯片的生产,并在 2027 年实现可行性演示,最终期望在 2030 年前实现商业化。软银在此合作中扮演了关键的投资者角色,已决定初期投入 30 亿日元,成为最大的出资方。整个项目的总成本预计将达到 100 亿日元(约合 7000 万美元),除了英特尔和软银,日本的理化学研究所(Institute of Physics and Chemistry)和新光电气工业(Shinko Electric Industry)等机构和企业也在考虑投资和技术合作,并可能寻求国家层面的财政支持。

当前,人工智能处理器,特别是用于大规模模型训练和推理的 GPU,高度依赖 HBM 来满足其巨大的数据吞吐需求。HBM 通过堆叠多层 DRAM 芯片并采用硅通孔(TSV,Through Silicon Via)技术实现极高的带宽,但其制造成本高昂、工艺复杂、功耗较大且发热严重。随着 AI 应用的爆炸式增长,对 HBM 的需求激增,导致三星、SK 海力士和美光这三大主要供应商的产能持续紧张,价格也居高不下。

Saimemory 项目的核心目标,正是要攻克 HBM 在功耗和成本上的瓶颈。报道称,通过优化 DRAM 芯片的堆叠方式和内部连接线路的结构,Saimemory 旨在将存储器在 AI 运算过程中的瞬时数据处理功耗降低至现有产品的一半以下。如果成功,这不仅能大幅降低 AI 数据中心的运营成本,尤其是在能源供应日益紧张的背景下,还将有助于构建更高效、更环保的 AI 基础设施。