AI连电路图都看不懂?SeePhys新基准暴击多模态短板,正确率低至55%

当前顶尖 AI 模型是否真能 " 看懂 " 物理图像?

全谱系多模态物理推理新基准来了,结果SOTA 级模型准确率都不足 55%。

新基准名为 SeePhys,强调了图形感知对于模型认识和理解物理世界的重要性。

内容涵盖经典与现代物理的各个知识等级和领域,包括从初中到博士资格考试的全谱系多模态物理问题。

它由中山大学、苏黎世联邦理工学院、华为诺亚方舟实验室和香港大学的研究团队联合推出,于近日正式开源。

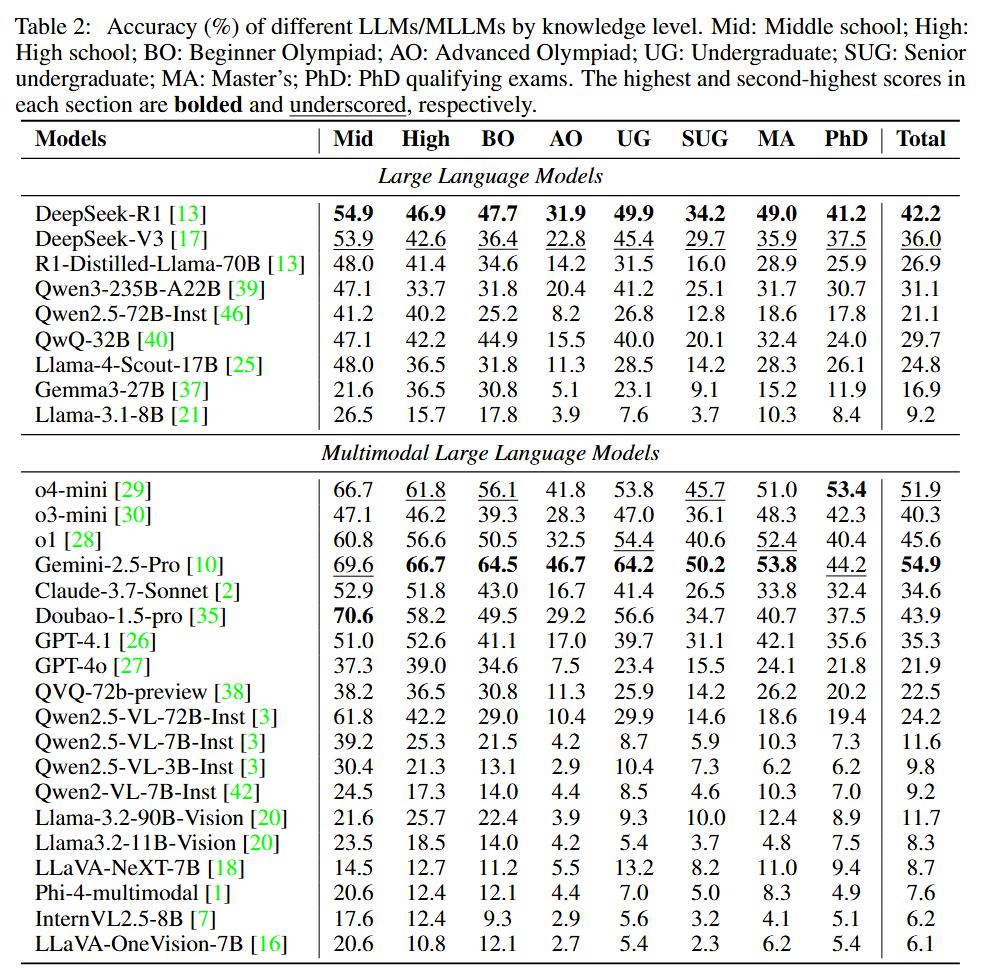

团队在实验中系统性评估了 LLM/MLLM 在复杂科学图表与理论推导耦合任务中的表现。

结果表明即使是 Gemini-2.5-Pro 和 o4-mini 等 SOTA 模型准确率都不足 55%,暴露出多模态推理的巨大挑战。

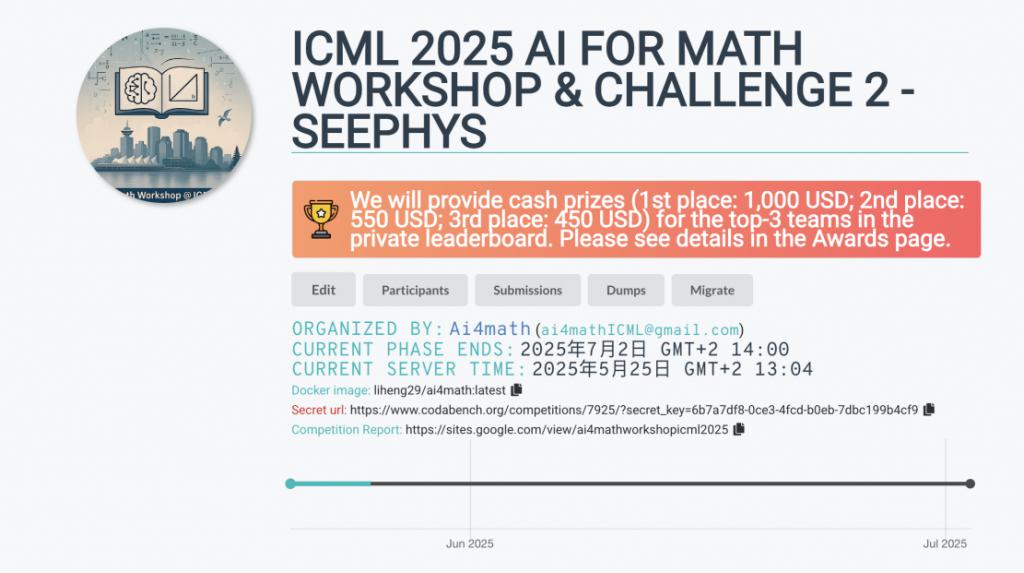

团队表示,目前该基准正在 ICML 2025 AI for MATH Workshop 中开放评估,欢迎学界与工业界的团队来挑战。

为什么需要 SeePhys?

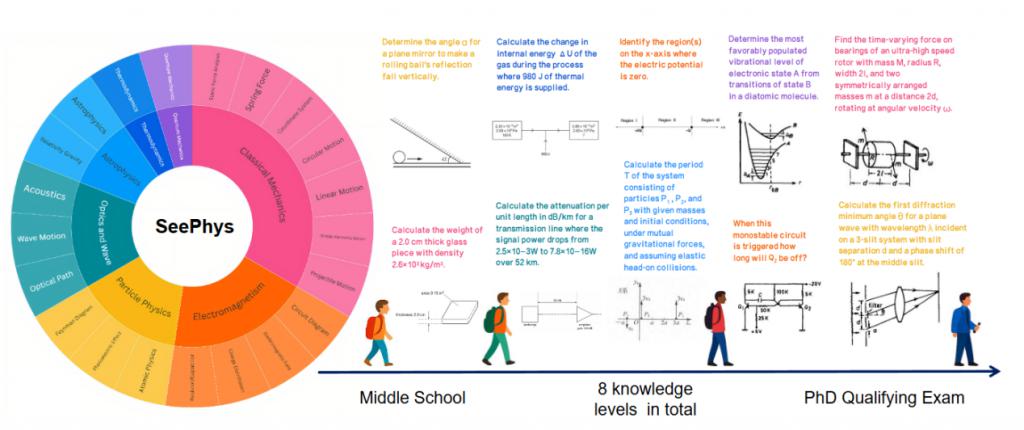

近年来,数学在大语言模型(LLMs)的推理能力评估中大放异彩,而物理学由于其具有与真实场景的强相关性和更复杂的图像信息,正在多模态测评中得到越来越多的重视。

物理学不仅知识体系庞大、逻辑链条复杂,而且天然地将抽象世界规律与千变万化的视觉图像紧密结合。无论是电路图、受力分析图,还是费曼图等,都挑战了多模态大模型根据图表理解世界本质规律的能力。

现有物理学基准或缺乏视觉组件,或仅覆盖单一的知识层级,难以全面评估模型的物理思维能力。

SeePhys 的诞生填补了这一空白,它旨在回答当前的顶尖 AI 模型是否真的 " 看懂 " 了物理图像,并能像人类科学家一样结合图像进行思考。

SeePhys 的独特之处在于:

知识层级跨度大:从初中到博士,从经典力学到量子场论,全面覆盖了不同知识阶段和研究领域;

强视觉依赖:根据图表是否包含必要解题信息进行分类,优先选择具有强视觉依赖的问题;

跨模态耦合:纯多模态基准,需同步处理符号公式、几何关系与真实世界建模。

具体来看,SeePhys 具有以下几个关键属性。

首先是全谱系覆盖:

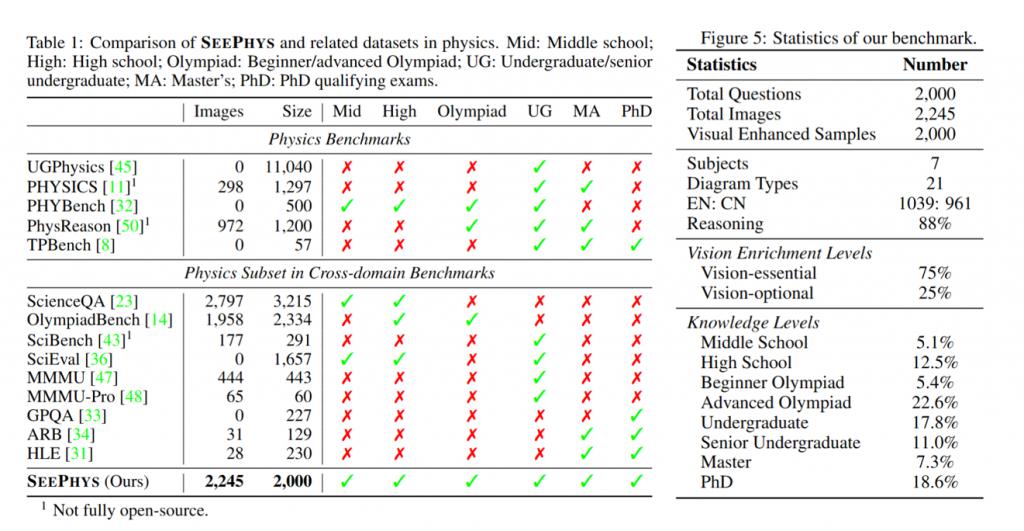

2000 道题目 +2245 张图表,涵盖 7 大物理领域(经典力学、电磁学、量子物理等);

8 个知识层级:初中、高中、奥赛(初级 / 高级)、本科(低年级 / 高年级)、硕士、博士资格考试;

21 类异构图表:包括电路图、时空曲率图、光电效应示意图等。

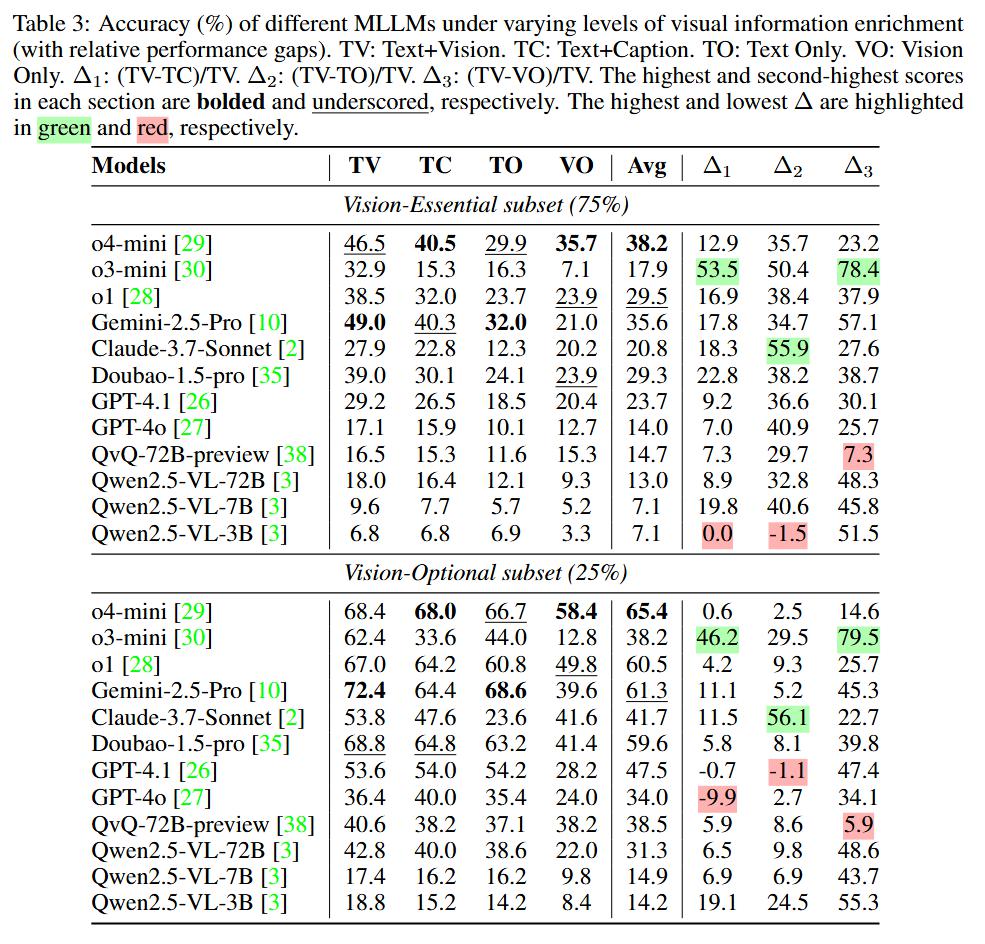

其次是不同的视觉富集程度:

Vision-Essential(75%):图表含解题必需信息(如坐标系数值、电路拓扑、费曼图);

Vision-Optional(25%):图表仅辅助说明(如场景示意图)。

还有多模态增强设计:

提供纯视觉副本(问题文本与图表融合为单张高分辨率图像);

四种评估模式:文本 + 图表(TV)、文本 + 描述(TC)、纯文本(TO)、纯视觉(VO)。

实验发现

通过对 28 个主流模型(包括 o4-mini、Gemini-2.5-Pro、Claude-3.7-Sonnet 等)的大规模测试,研究团队总结以下结论:

视觉 - 文本对齐能力的缺陷:

最佳模型 Gemini-2.5-Pro 准确率仅 54.9%,即使是初中物理题正确率也不及 70%。

纯语言模型表现意外接近多模态模型,如 DeepSeek-R1(42.2%) vs o3-mini(40.3%),且模型在视觉依赖性较低的问题中准确率远高于视觉信息富集的问题,暴露了当前顶尖 MLLM 仍存在巨大的视觉 - 文本对齐问题。

模型对特定图表类型(波动方程图、电路图)存在系统性识别障碍。

" 看见 " 对于 " 思考 " 的重要性:

对于视觉富集的问题,添加对图像的文本描述和直接输入图文交织问题均相对纯文本问题提升巨大。

即使是非必要性图表也能辅助模型理解问题(如 Claude-3.7-Sonnet 在 Text+Vision 条件下相对 Vision Only 准确率提升 30.2%),表明适当的视觉提示能够帮助模型理解问题本质。

知识注入显现出边际效应:

较弱模型(如 Qwen2.5-VL-3B 和 LLaVA-OneVision-7B)由于灾难性遗忘现象,在高年级问题上精度下降幅度巨大,而较强模型则下降较为平缓,表明知识注入带来的性能提升已经初步显现边际效应。

当前模型更擅长记忆而非逻辑推理(如高级奥赛题反而比知识考察更深的博资考的准确率更低)。

即使是初中和高中难度的物理题也并未被 AI 完全解决,物理学对于 MLLM 依然十分困难。

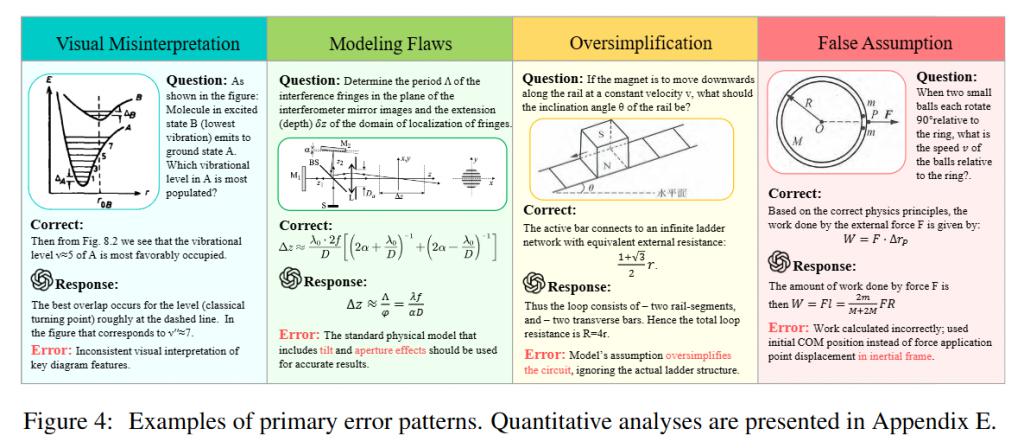

错误推理模式归纳

研究团队对强模型 o4-mini, Gemini-2.5-Pro 与弱模型 Qwen2.5-VL-3B 共同错误的 100 个样本进行人工分析。

然后,归纳得出了 9 种错误的推理模式,包括视觉误读、文本误读、建模错误、错误假设、数值计算错误、过度简化、总结错误、过度思考和重复输出。

所有三个模型都表现出明显的建模缺陷(例如定理和公式误用),同时表现出相对较少的文本误读和数值计算错误。

而过度思考和过度简化的错误频率在模型之间存在显著差异,且较小的 Qwen2.5-VL-3B 出现了高重复输出率(21%)。

参赛链接:https://www.codabench.org/competitions/7925/

挑战赛详细信息:https://sites.google.com/view/ai4mathworkshopicml2025/challenge

ICML workshop 主页:https://sites.google.com/view/ai4mathworkshopicml2025/home

论文:https://arxiv.org/pdf/2505.19099

项目主页:https://github.com/SeePhys/seephys-project

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

点亮星标

科技前沿进展每日见